DreamActor-M1 From ByteDance

DreamActorM1 è un framework di animazione umana basato su trasformatori di diffusione, con guida ibrida per raggiungere un controllo olistico a grana fine, adattabilità multiscala e coerenza temporale a lungo termine.

Elencato nelle categorie:

VideoStrumenti di designGitHub

Descrizione

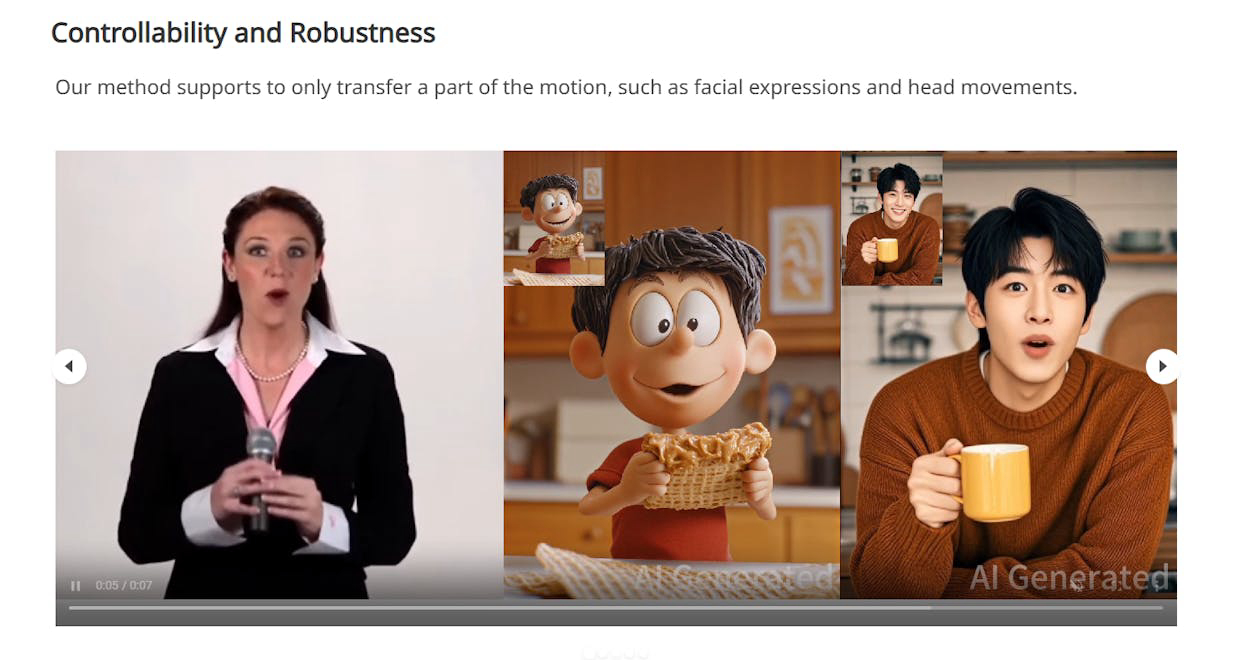

DreamActorM1 è un framework di animazione umana basato su DiT che utilizza una guida ibrida per ottenere un controllo olistico dettagliato, un'adattabilità multiscala e una coerenza temporale a lungo termine. Può imitare i comportamenti umani catturati da video, producendo video umani altamente espressivi e realistici su più scale, dalle animazioni in ritratto alle animazioni a corpo intero. I video risultanti sono temporaneamente coerenti, preservano l'identità e sono di alta fedeltà.

Come usare DreamActor-M1 From ByteDance?

Per utilizzare DreamActorM1, gli utenti devono fornire un'immagine di riferimento o più fotogrammi da un video di input. Il framework estrae quindi scheletri corporei e sfere per la testa dai fotogrammi di guida, li codifica e li combina con il video latente per generare animazioni espressive. Gli utenti possono controllare vari aspetti dell'animazione, comprese le espressioni facciali e i movimenti del corpo, attraverso il sistema di guida ibrida.

Funzionalità principali di DreamActor-M1 From ByteDance:

1️⃣

Controllo olistico dettagliato

2️⃣

Adattabilità multiscala

3️⃣

Coerenza temporale a lungo termine

4️⃣

Controllo robusto delle espressioni facciali e dei movimenti del corpo

5️⃣

Supporto per animazione facciale guidata da audio con capacità di sincronizzazione labiale

Perché potrebbe essere usato DreamActor-M1 From ByteDance?

| # | Caso d'uso | Stato | |

|---|---|---|---|

| # 1 | Creazione di animazioni umane espressive per film e giochi | ✅ | |

| # 2 | Generazione di avatar realistici per ambienti di realtà virtuale | ✅ | |

| # 3 | Produzione di contenuti animati per social media e marketing | ✅ | |

Sviluppato da DreamActor-M1 From ByteDance?

DreamActorM1 è sviluppato da un team di ricercatori tra cui Yuxuan Luo, Zhengkun Rong, Lizhen Wang, Longhao Zhang, Tianshu Hu e Yongming Zhu, affiliati a Bytedance Intelligent Creation. Il team ha dato contributi equivalenti allo sviluppo di questo innovativo framework di animazione umana.